在操作進階的 SEO 時,為了有效利用搜尋引擎分配給每個網站的爬取資源,我們會修改 robots.txt 來給予正確的搜尋引擎指示,進一步的達成優化 SEO 的效果。

內容目錄

Togglerobots.txt 是一種文字檔案,通常位於網站的根目錄下,用於告訴搜索引擎的爬蟲(也稱為網路機器人)哪些網頁可以被抓取,哪些網頁不能被抓取。通過將 robots.txt 文件放在網站的根目錄下,網站管理員可以控制搜索引擎在什麼時候、以什麼樣的方式訪問他們的網站。例如,robots.tx t可以屏蔽某些頁面或目錄的內容,從而保護網站的隱私或有效的利用搜尋引擎的爬蟲資源,合理地設置 robots.txt 文件可以提高網站的SEO效果。需要注意的是,robots.txt文件只是一種道德規範,並不能完全保證搜索引擎爬蟲不會訪問被禁止訪問的網頁或目錄,因此網站管理員還需要採取其他措施來確保網站的安全。

robots.txt 文件的格式一般為 UTF-8 編碼的文字檔案,其內容包含一條或多條記錄,每個記錄由一行或多行組成,每行以一個欄位和一個冒號開始,後跟該欄位的值。其中,欄位可以是以下之一:User-agent、Disallow、Allow、Sitemap。

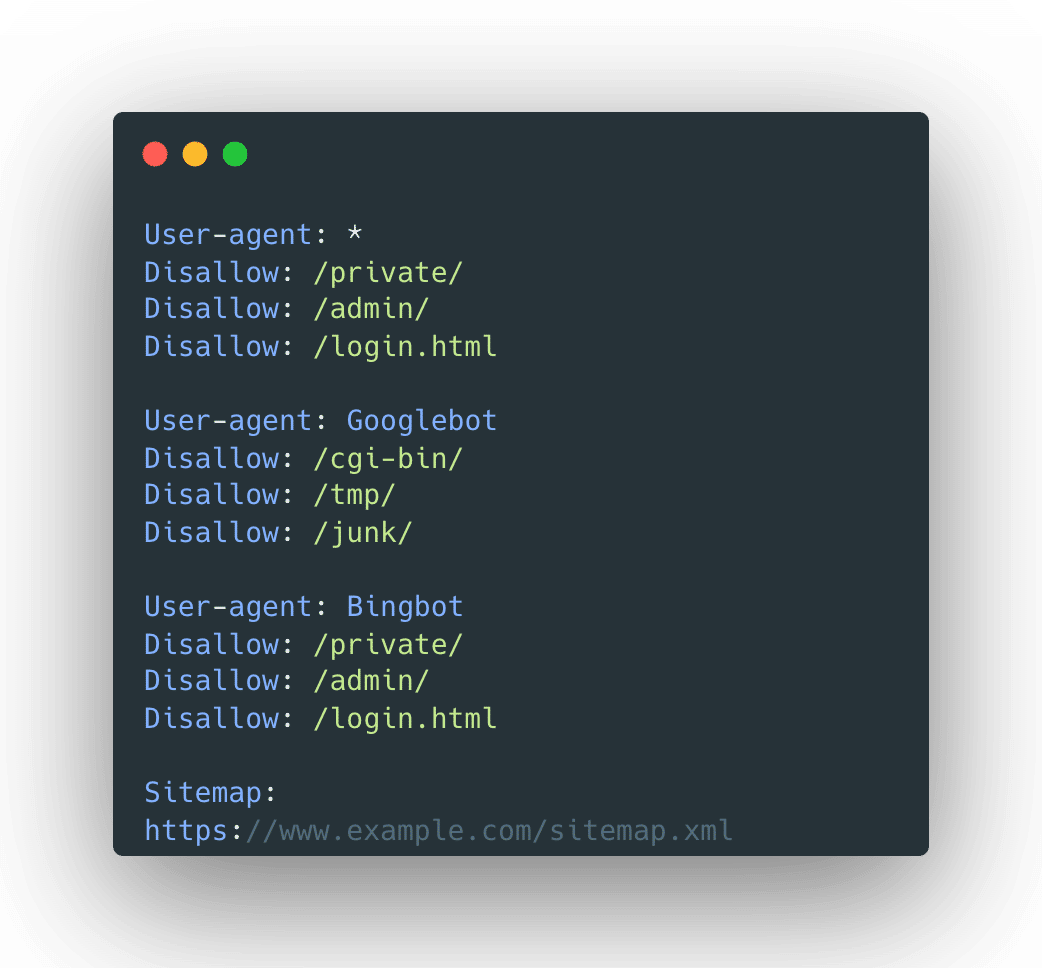

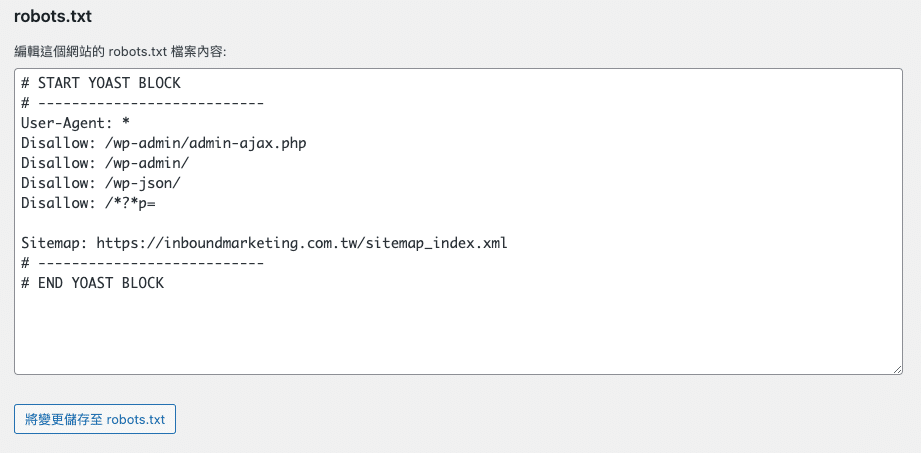

如果你想要編寫 robots.txt 文件,你可以使用任何的文字編輯器,最終儲存時只要是 .txt 檔案格式即可。以下是一個 robots.txt 文件編寫的範例:

User-agent: * Disallow: /private/ Disallow: /admin/ Disallow: /login.html User-agent: Googlebot Disallow: /cgi-bin/ Disallow: /tmp/ Disallow: /junk/ User-agent: Bingbot Disallow: /private/ Disallow: /admin/ Disallow: /login.html Sitemap: https://www.example.com/sitemap.xml

上述 robots.txt 文件包括三個 User-agent 指令區塊,一個Sitemap指令區塊。第一個User-agent 指令區塊使用萬用字元 “*”,表示適用於所有搜索引擎爬蟲。此指令區塊中,Disallow指令告訴搜索引擎爬蟲不應該訪問 /private/、/admin/ 以及 /login.html三個網頁或目錄。

第二個 User-agent 指令區塊是為 Googlebot 搜索引擎爬蟲而設的,其中的 Disallow 指令告訴 Googlebot 搜索引擎爬蟲不應該訪問 /cgi-bin/、/tmp/、/junk/ 三個網頁或目錄。

第三個 User-agent 指令區塊是為 Bingbot 搜索引擎爬蟲而設的,其中的 Disallow 指令告訴 Bingbot 搜索引擎爬蟲不應該訪問 /private/、/admin/ 以及 /login.html 三個網頁或目錄。

最後一個 Sitemap 指令區塊告訴搜索引擎,網站的Sitemap文件位於 https://www.example.com/sitemap.xml 。這將幫助搜索引擎更好地瞭解網站的結構和內容,從而提高網站的可見性和可訪問性。

需要注意的是,robots.txt 文件中的語法非常重要。一個錯誤的語法可能導致搜索引擎無法正確解析文件,進而對網站產生負面影響。網站管理員應該遵循 robots.txt 文件的語法要求,確保文件能夠正確地被搜索引擎解析和執行。

一般來說 robots.txt 檔案並不需要主動提交,只需要將它放置於網站的根目錄即可。例如你的網站網域為 www.my.org ,那麼你只要將 robots.txt 檔案放置在 www.my.org/robots.txt 這個位置即可。

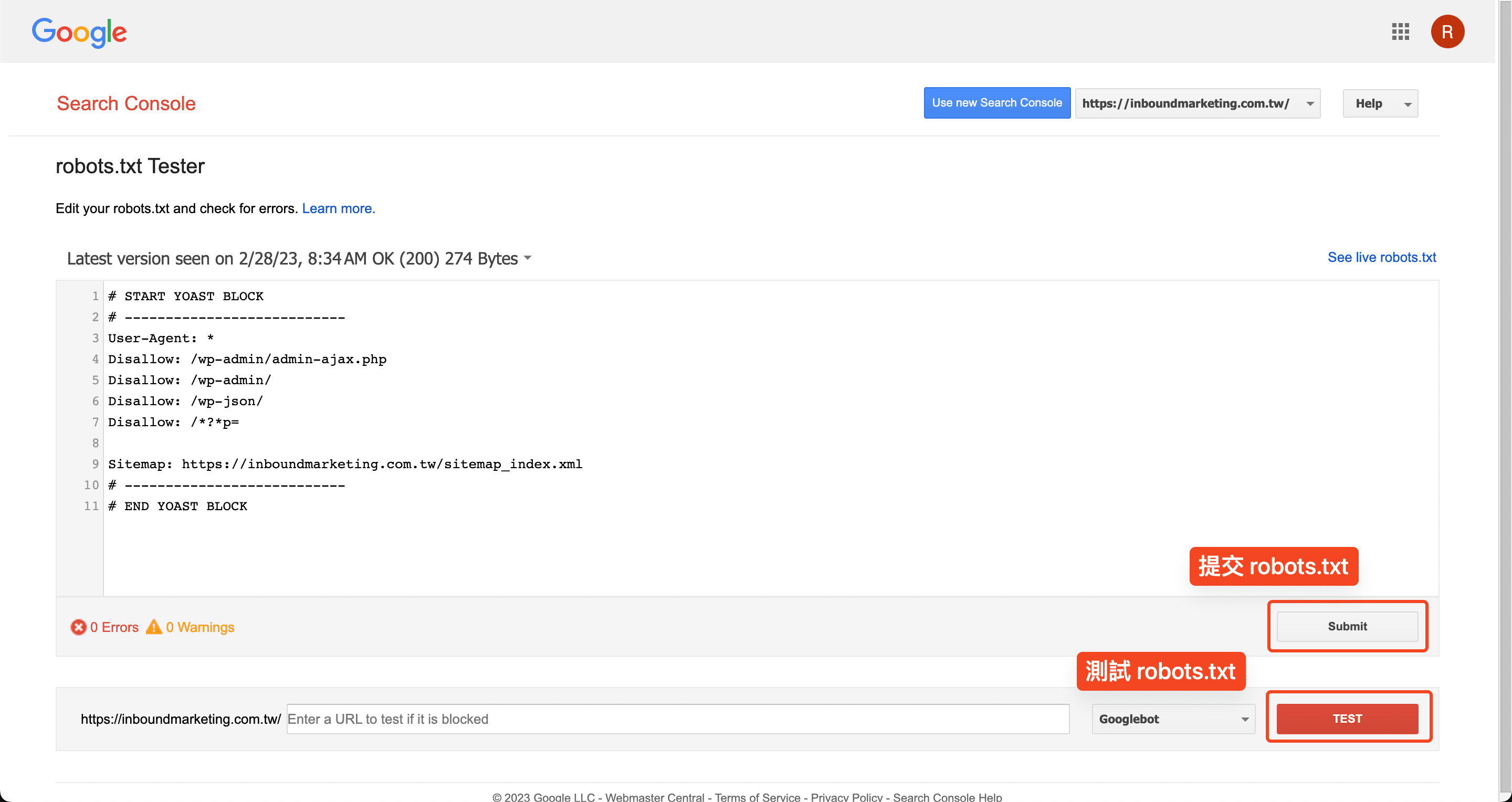

在提交 robots.txt 文件時,需要注意以下幾點:

如果你因為一些因素想要 Google 盡快處理你的更新,你可以主動的前往 Search Console 的 robots.txt 測試工具提交 robots.txt 檔案,你可以參考 Google 官方文件該使用 robots.txt 測試工具檢測 robots.txt。

robots.txt 和 sitemap 是兩個不同的文件,但它們都與搜索引擎的爬蟲行為有關。通過合理設置 Robots.txt 文件和 sitemap 文件,網站管理員可以控制搜索引擎爬蟲的行為,提高網站的可訪問性和可見性。我們可以在 robots.txt 裡指定 sitemap 的位置,明確的指示搜尋引擎該處理哪一些 sitemap。

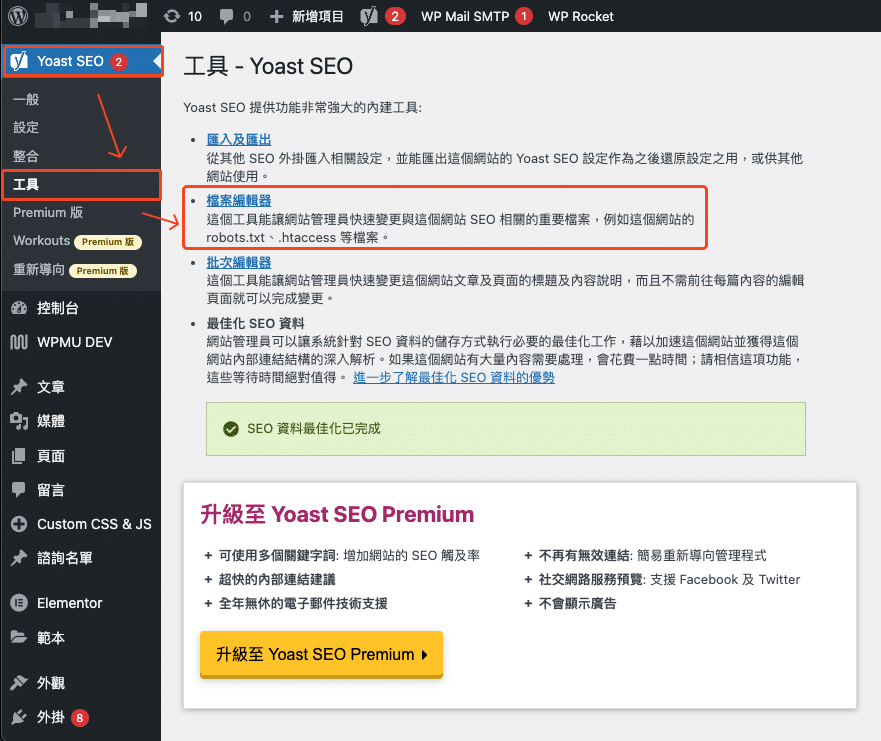

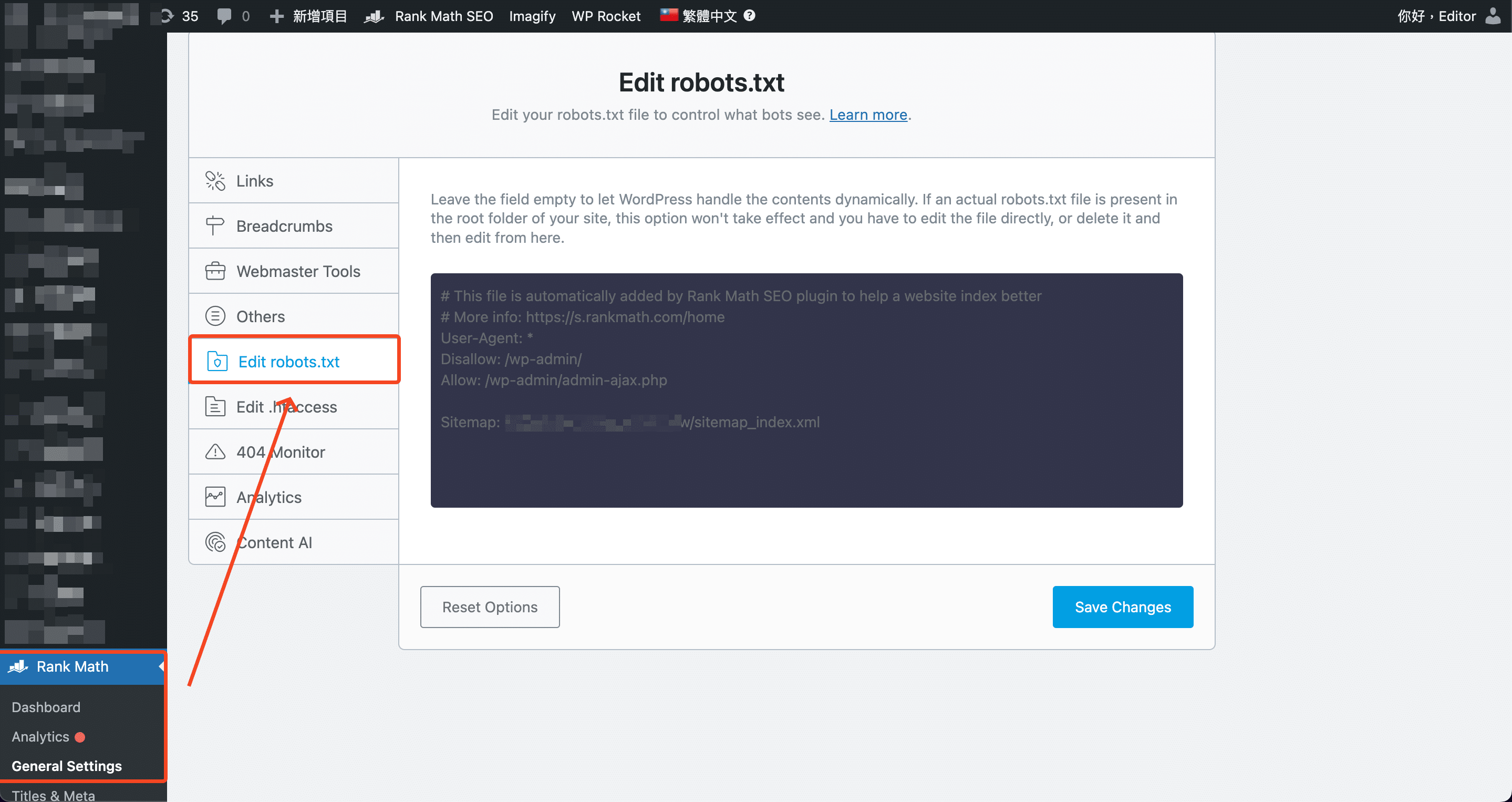

在後台左側找到 Rank Math,前往 General Settings 裡的 Edit robots.txt 即可編輯 robots.txt

行銷人員在選擇 SEO 優化服務公司最常感到疑惑的是,為什麼同樣是排名優化,價差會這麼多,其實這些差別來自於你選的SEO公司是否使用黑帽SEO(Black Hat SEO),而什麼是黑帽SEO呢?跟白...

網路行銷公司可以準確分析你的網站流量及行銷成效,究竟是透過什麼方式呢?答案很可能是透過設置UTM參數,在Google Analytics中查看報表。那麼UTM是什麼呢?接下來將帶你認識UTM的功能與用...

Google 搜尋引擎已經成為我們日常生活不可脫離的一部分,無論你是業主、行銷人員、開發人員或是 SEO 專業人員,我們在網站架設好後的疑問通常都是「我的網站是否會顯示在 Google 搜尋結果當中嗎...